Você pode enganar a visão geral da IA do Google para explicar idiomas inventados

Como grandes Tech derrama inúmeros dólares e recursos na IAPregando o Evangelho de seu brilho criativo na utopia, aqui está um lembrete de que os algoritmos podem estragar tudo. Grande momento. A evidência mais recente: você pode enganar Visão geral da AI do Google (As respostas automatizadas no topo de suas consultas de pesquisa) para explicar idiomas fictícios e sem sentido como se fossem reais.

De acordo com a visão geral da AI do Google (via @Egregionr em bluesky), “Você não pode lamber um texugo duas vezes” significa que você não pode enganar ou enganar alguém uma segunda vez depois de ter sido enganado uma vez.

Parece uma tentativa lógica de explicar o idioma – se apenas não fosse Poppycock. A falha movida a Gêmeos do Google ocorreu assumindo que a pergunta se referiu a uma frase estabelecida, em vez de Mumbo Jumbo absurdo, projetado para enganá-la. Em outras palavras, Alucinações da AI ainda estão vivos e bem.

Nós conectamos um pouco de bobagem a nós mesmos e encontramos resultados semelhantes.

A resposta do Google afirmou que “você não pode golfe sem peixe” é um enigma ou brincar com palavras, sugerindo que você não pode jogar golfe sem o equipamento necessário, especificamente, uma bola de golfe. Divertidamente, a visão geral da IA acrescentou a cláusula de que a bola de golfe “pode ser vista como um” peixe “devido à sua forma”. Hum.

Depois, há o velho ditado: “Você não pode abrir uma jarra de manteiga de amendoim com dois pés esquerdos”. De acordo com a visão geral da IA, isso significa que você não pode fazer algo exigindo habilidade ou destreza. Novamente, uma facada nobre em uma tarefa atribuída sem recuar para verificar a existência do conteúdo.

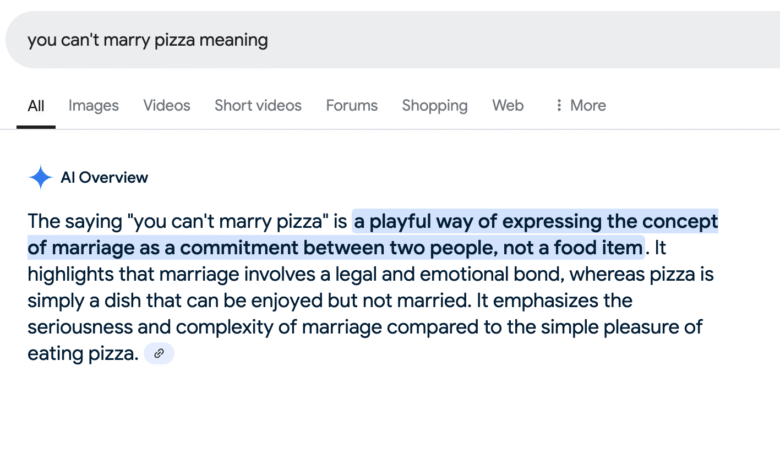

Há mais. “Você não pode se casar com pizza” é uma maneira divertida de expressar o conceito de casamento como um compromisso entre duas pessoas, não um item de comida. (Naturalmente.) “A corda não puxará um peixe morto” significa que algo não pode ser alcançado apenas pela força ou esforço; Requer vontade de cooperar ou uma progressão natural. (É claro!) “Coma o maior Chalupa First” é uma maneira divertida de sugerir que, ao enfrentar um grande desafio ou uma refeição abundante, você deve primeiro começar com a parte ou item mais substancial. (Sábio Conselho.)

Este é dificilmente o primeiro exemplo de alucinações de IA que, se não forem verificadas pelo usuário, poderiam levar a informações erradas ou conseqüências da vida real. Basta perguntar Os advogados do ChatGPTSteven Schwartz e Peter Loduca, que eram multado em US $ 5.000 em 2023 Para usar o ChatGPT para pesquisar um resumo no litígio de um cliente. O AI Chatbot gerou casos inexistentes citados pelo par que os advogados do outro lado (compreensivelmente) não conseguiram localizar.

A resposta do par à disciplina do juiz? “Cometemos um erro de boa fé ao não acreditar que uma peça de tecnologia poderia estar inventando casos de tecido inteiro”.

Este artigo apareceu originalmente em Engadget em https://www.engadget.com/ai/you-can-trick-googles-ai-overviews-into-explaining-up-idioms-162816472.html?src=rsss

Source link